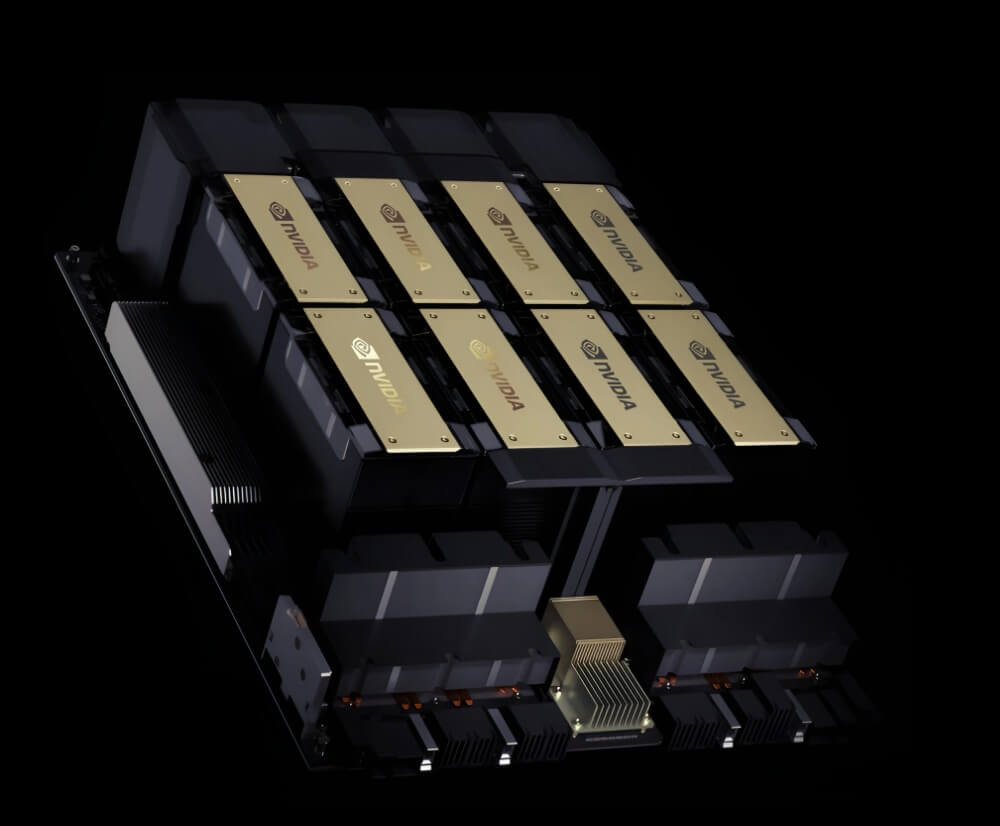

NVIDIA HGX H100 8 GPU

エンタープライズAIの新基準

エンタープライズAIの新基準

NVIDIA HGX H100は、最新のHopperアーキテクチャを採用し、AIワークロードに最適化された高性能GPUプラットフォームです。大規模言語モデル(LLM)や生成AI向けに設計された革新的な性能を提供します。

NVSwitch™とNVLink™テクノロジーにより、複数のGPU間で最大900GB/秒の双方向帯域幅を実現。大規模なAIモデルのトレーニングや推論において、優れたスケーラビリティを発揮します。

サーバーメーカーやクラウドプロバイダーを通じて、様々な形態でHGX H100のパワーを活用できます。エンタープライズAIインフラストラクチャの構築に最適なプラットフォームを提供します。

| 仕様 | HGX H100 8-GPU | HGX H200 8-GPU |

|---|---|---|

| GPUメモリ | 640GB HBM3 | 141GB HBM3e |

| メモリ帯域幅 | 3.35 TB/s | 4.8 TB/s |

| FP8 Tensor演算性能 | 3,200 TFLOPS | 4,000 TFLOPS |

| FP16/BF16 Tensor演算性能 | 1,600 TFLOPS | 2,000 TFLOPS |

| TF32 Tensor演算性能 | 800 TFLOPS | 1,000 TFLOPS |

| FP64 Tensor演算性能 | 48 TFLOPS | 60 TFLOPS |

| メモリインターフェイス | 5120-bit HBM3 | 6144-bit HBM3e |

| TDP(最大消費電力) | 700W(設定可能) | 700W(設定可能) |

AIの開発、運用に欠かせないGPUサーバー。選定にあたり様々なポイントがありますが、その中でも特に重要な3つのポイントをお伝えいたします。

GPUの主な用途には、生成AI、ブロックチェーン、映像処理などがあり、活用の用途に応じてユーザーはGPUモデルを検討します。間違えやすいポイントとしてはGPUが全てを握る鍵なのではなく、実はお客様のアプリケーション環境や使用するソフトウェアにパフォーマンスが大きく依存する点です。トゥモロー・ネットでは、数多くのGPUサーバーを構築した知見を活かし、お客様の環境を細かくヒアリングし、その上でお客様の環境に最適な製品の提案を行っています。

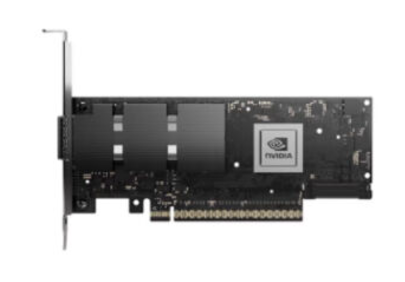

NVIDIA製GPUには、PCIeとSXMという2種類の主要なインターコネクトテクノロジーが存在します。PCIeはコストを抑え、基本的な機能を備えた汎用性の高いテクノロジー。AIに特化せず様々な用途に利用可能な一方でパフォーマンスは環境に依存します。SXMはAIアプリケーションなどの高パフォーマンスを求める場合に多く利用されるテクノロジー。トゥモロー・ネットではSXMタイプのGPUをSupermicroサーバーと一体化し提供することで、お客様により高いパフォーマンスと保守を兼ね備えたインフラを提供します。

GPU Direct RDMAは、高性能なNIC(ネットワークインターフェースカード)を使用して、RDMA(Remote Direct Memory Access)を実現します。このシステムでは、通常のネットワーク通信に比べて遅延が少なく、高速なデータ転送が可能です。NVIDIA BlueField-3 DPUは、データセンター、クラウド、エッジからコアまでのインフラストラクチャを高速化、分離、保護する、次世代のオンチップ型データセンターインフラストラクチャプラットフォームです。AI用のインフラを構築する場合はGPUだけではなくサーバー全体のスペックを考慮することが非常に重要です。

(1台当たり標準仕様明細)

AI、複雑なシミュレーション、大規模なデータセットには、複数のGPUを超高速接続で結び、完全に加速されたソフトウェアスタックが必要です。NVIDIA HGX AIスーパーコンピューティングプラットフォームは、NVIDIA GPU、NVIDIA NVLink、NVIDIAネットワーキングと完全に最適化されたAIおよび高性能コンピューティング(HPC)ソフトウェアスタックを組み合わせ、最高のアプリケーションパフォーマンスを提供し、迅速なインサイトの導出を可能にします。

NVIDIA HGX H100は、H100 Tensor Core GPUと高速インターコネクトを組み合わせ、世界で最も強力なサーバーを形成します。最大8基のGPUを構成し、最大80ギガバイト(GB)のHBM3メモリ、毎秒3.35テラバイト(TB/s)の総メモリ帯域幅を提供し、前例のない加速性能を実現します。これにより、最大32 PFLOPSという驚異的なパフォーマンスが組み合わさり、AIおよびHPC向けの世界で最も強力な加速スケールアップサーバープラットフォームが生まれます。

NVIDIA HGX H100には、最大400ギガビット毎秒(Gb/s)の速度を可能にするNVIDIA Quantum-2 InfiniBandおよびSpectrum-X Ethernetを活用した高度なネットワーキングオプションが含まれています。また、クラウドネイティブ、ハイパースケールAIクラウドおよびGPUクラスターの柔軟性を可能にするNVIDIA BlueField-3データ処理ユニット(DPU)も搭載されています。