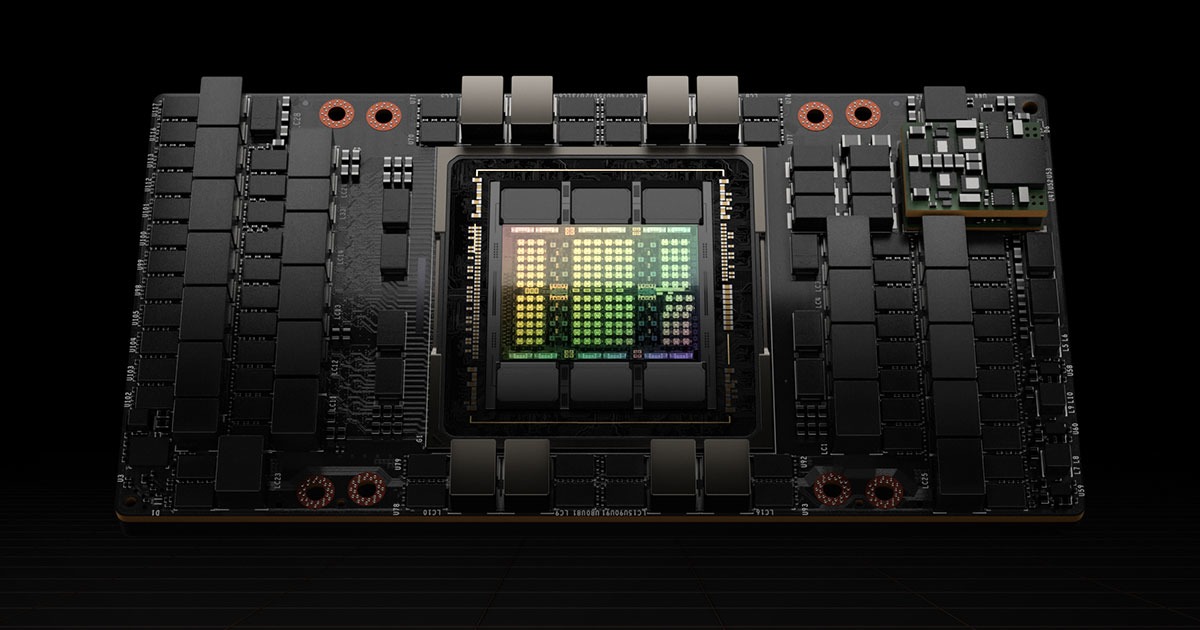

NVIDIA H100 Tensor Core GPU

次世代のAIコンピューティングを実現する革新的なGPUアーキテクチャ

AIトレーニング

高速な学習処理

第4世代Tensor Coreと新しいTransformer Engineにより、AIモデルのトレーニング速度を大幅に向上

AI推論処理

効率的な推論実行

FP8精度での演算に対応し、より高速で効率的な推論処理を実現。生成AIやLLMの実行を加速

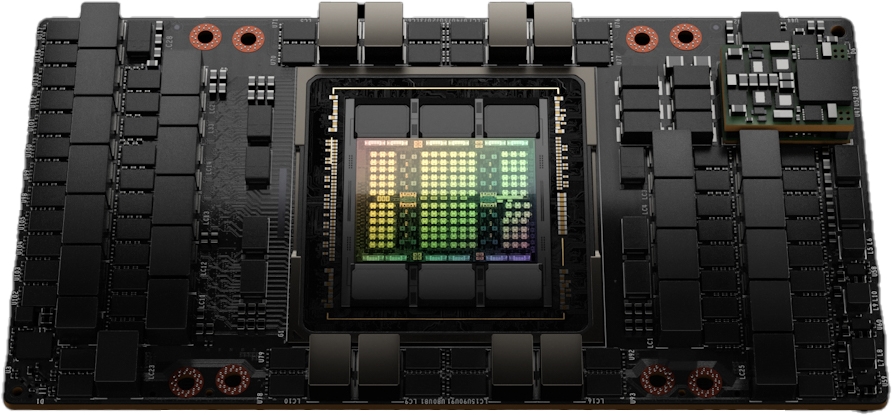

HBM3メモリ

大容量高速メモリ

80GB HBM3メモリを搭載し、3.35 TB/秒の超高速メモリ帯域幅により、大規模モデルの処理を実現

次世代アーキテクチャ

Hopperアーキテクチャ

NVIDIAの最新GPUアーキテクチャを採用し、AIワークロードに最適化された革新的な処理性能を提供